求职意向

大数据 北京 薪资面议 随时到岗

教育背景

2020.x -2020x 锤子简历大学 软件工程

曾任职学生会宣传部部长

工作经验

2020.x -2020x

项目经验

2020.x -2020x 蜂鸟网商城 后台开发

该项目是基于B2C模式的电子商务网站,经营范围包括数码相机、镜头、胶片机、摄影必备、摄像机等。 本项目主要包括后台管理系统、前台交易系统、用户认证系统、搜索系统、支付系统及其周边系统采用SOA面向服务的分布式架构方式进行开发,并采用分布式和集群的方式将业务系统进行部署。

2020.x -2020x 用户日志采集分析平台 后台开发

项目描述: 数据统计分析平台针对用户不同行为记录用户一个Session中所有Action的日志。以这些日志为基础,通过大数据技术分析计算,平台对网站的各种用户行为(访问行为、购物行为、广告点击行为等)进行分析。从而帮助决策者更好地制定公司发展策略,最终达到用大数据技术来帮助提升公司的业绩、营业额以及市场占有率的目标。 项目主要使用了Spark Core,Spark Sql,Spark Streaming技术和Flume、Kafka、MapReduce、Hive、Zookeeper框架实现了用户访问 Session 统计的需求。

实习经验

2020.x -2020x 锤子简历信息技术有限公司 互联网电商

2017/08—至今:大数据相关开发

自我评价

为人稳重、大方,认真对待工作,开朗自信,待人真诚,有优良的团队精神,强烈的责任心,良好的沟通协调能力。决策能力、计划能力、谈判能力强,具备良好的敬业精神和职业道德操守,有很强的感召力和凝聚力。

【使用锤子简历小程序制作简历】

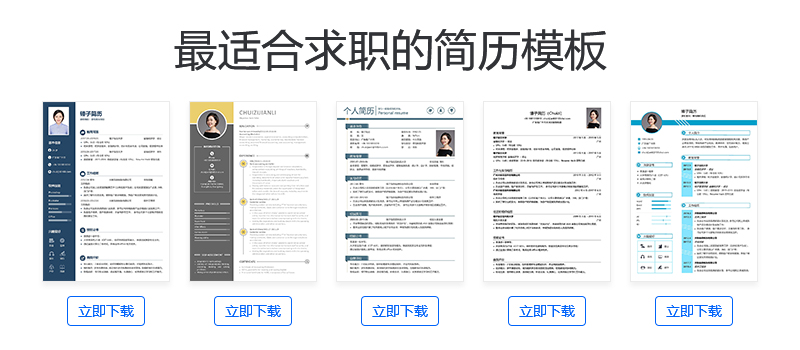

零经验实习简历模板

21254人用过

学生求职简历模板

52754人用过

申请研究生简历模板

2324人用过

经典工作简历模板

6254人用过

投行咨询简历模板

12465人用过

产品经理简历模板

7532人用过

程序员简历模板

7457人用过

留学英文简历模板

4554人用过